原文来源:量子位

图片来源:由无界 AI生成

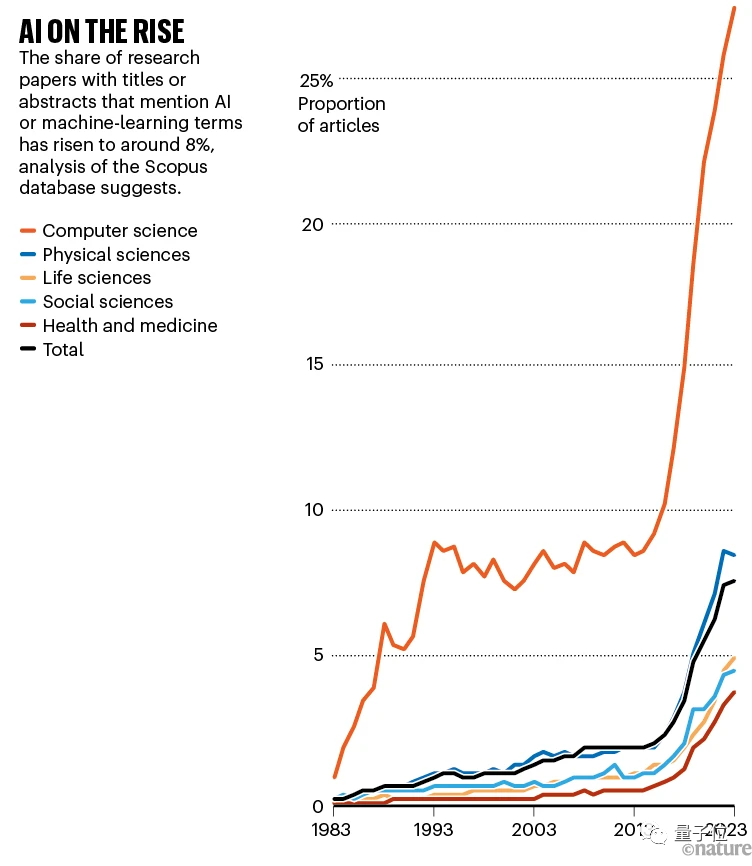

AI论文暴增,而真正觉得它是“刚需”的研究者,竟然只有4%?!

这一结论来自Nature的最新调查。

更准确一点,是对那些会在科学研究中使用AI工具的研究者的调查结果。

这些人是从2022年最后四个月发表了论文的4万多名研究者中挑选而出的,遍布全球,来自不同学科领域。

此外,开发AI工具的“局内人”和在研究中不使用AI工具的“局外人”也在调查之列,总调查人数达1600+。

目前相关结果已经以“AI and science: what 1,600 researchers think”为题刊出。

科学研究人员到底是如何看待AI工具的?我们接着往下看。

1600位研究人员的AI看法

这项调查主要集中于研究人员对机器学习和生成式AI的看法。

为了保证调查结果的客观有效,如上所述,Nature通过电子邮件联系了在2022年最后4个月内发表论文的来自世界各地的4万多名科学家,并邀请了Nature简报的读者参与调查。

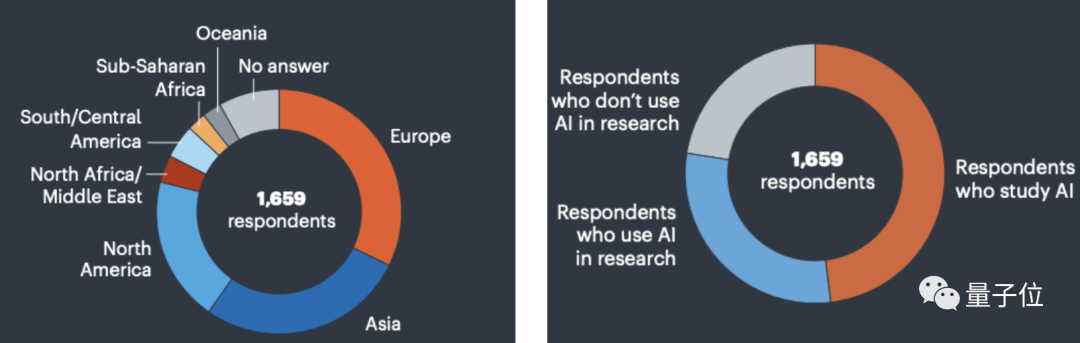

最终选出了1659位受访者,具体样本构成如下:

受访者中来自亚(28%)、欧(近1/3)、北美(20%)的人居多。

其中,48%的人直接开发或研究AI,30%的人在研究中使用AI,22%的人在研究中不使用AI。

下面来看详细结果。

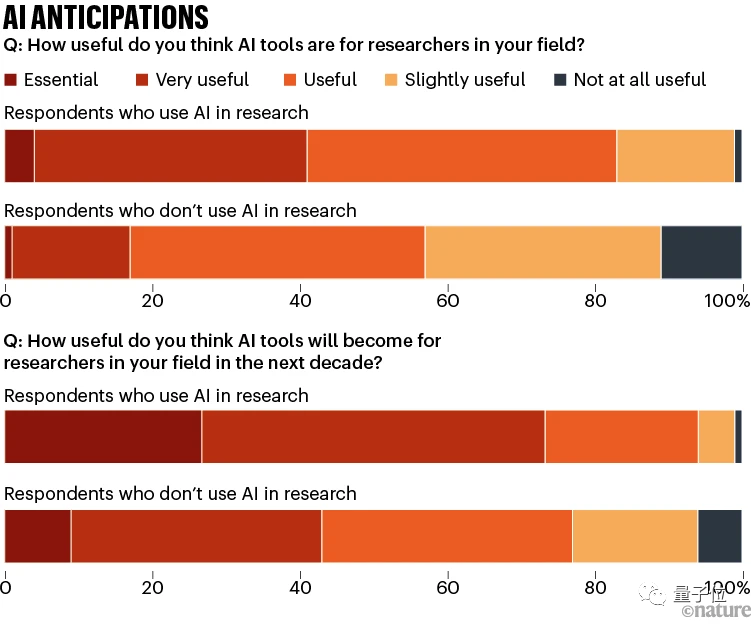

据调查,那些在研究中使用AI的人中,超1/4的人认为AI工具将在未来十年内成为他们所在领域的“必需品”。

但认为AI工具现在已是“必需品”的人只占4% ,另有47%的人认为人工智能未来将“非常有用”。

相较之下,不使用AI的研究人员对此并不是很感兴趣。即便如此,仍有9%的人认为这些技术将在未来十年内变得“必不可少”,另有34%的人表示它们将“非常有用”。

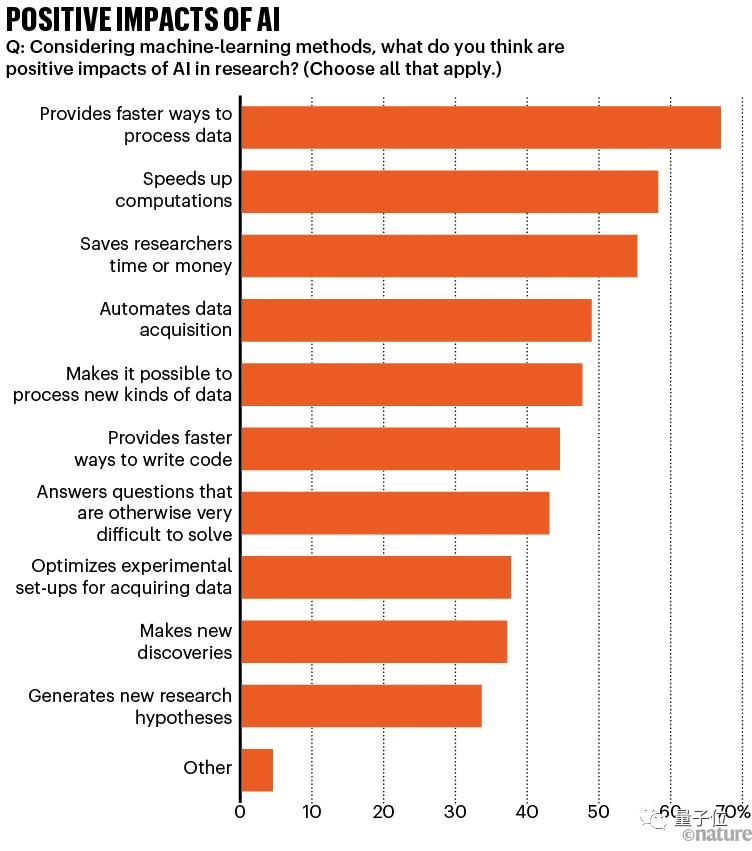

在对关于机器学习的看法调查中,受访者需选择AI工具所带来的积极作用。2/3的受访者认为AI提供了更快的数据处理方式,58%的人认为AI加速了以前不可行的计算,其次55%的人提到AI节省了时间和金钱。

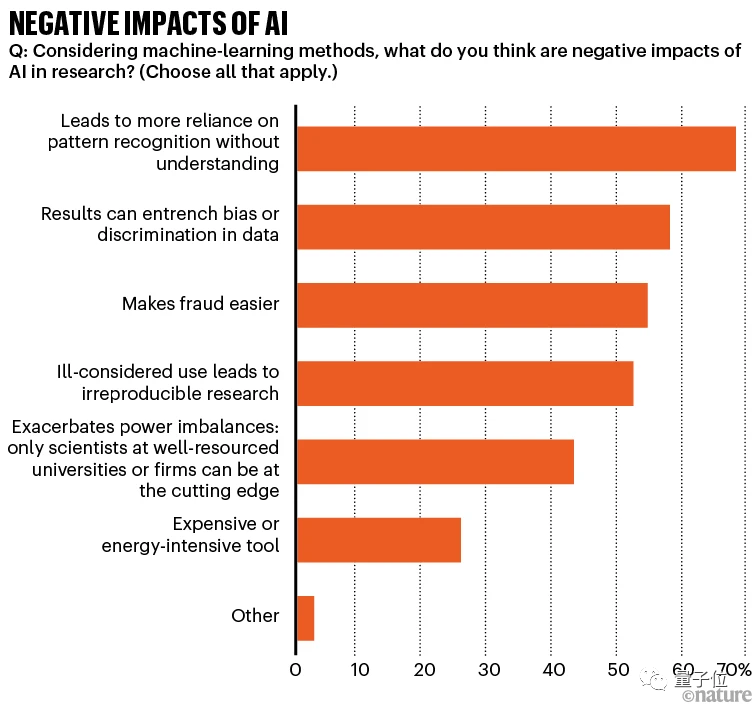

而受访者们认为的AI可能带来的消极作用主要有:导致更多地依赖模式识别而不是深刻理解(69%)、可能会在数据中强化偏见或歧视(58%)、可能会增加欺诈的发生概率(55% )、盲目使用可能会导致研究无法重现(53% )。

再来看研究人员对生成式AI工具的看法。

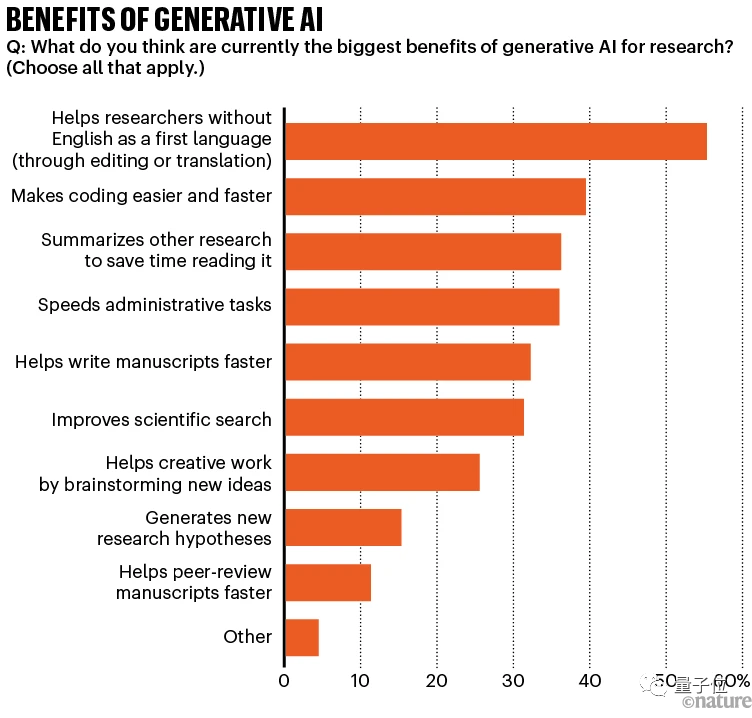

大多数人认为生成式AI工具的一大优点是总结和翻译, 可以帮助非英语母语的研究人员改进论文语法和风格。其次,其编写代码的能力也得到了赞同。

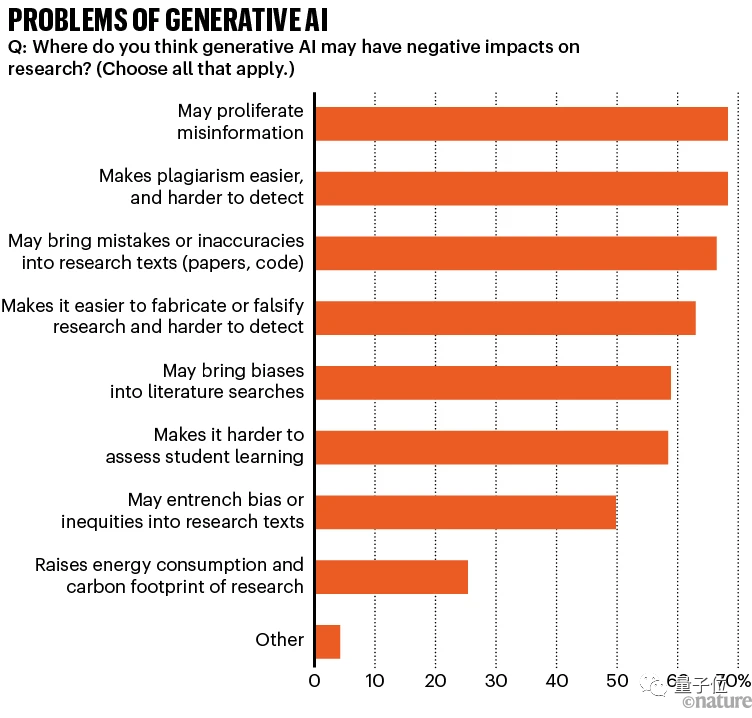

但是生成式AI也存在一些问题。研究人员最担心的是信息传播不准确(68%)、使抄袭更容易检测更难(68%)、在论文/代码中引入错误或不准确的内容(66%)。

受访者还补充道,如果用于医疗诊断的AI工具是基于有偏见的数据训练出来的,他们担心可能会出现伪造研究、虚假信息和长期存在的偏见。

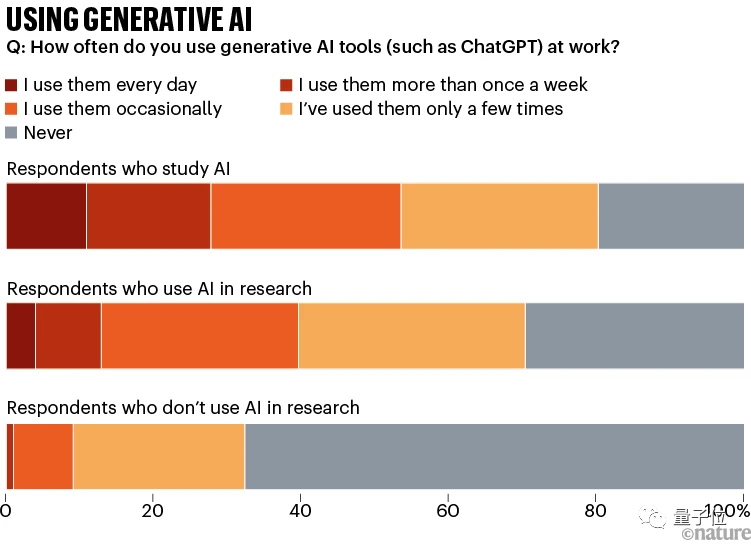

此外,根据使用频率统计,即使是对AI感兴趣的研究人员,在工作中经常使用大语言模型的仍然是少数。

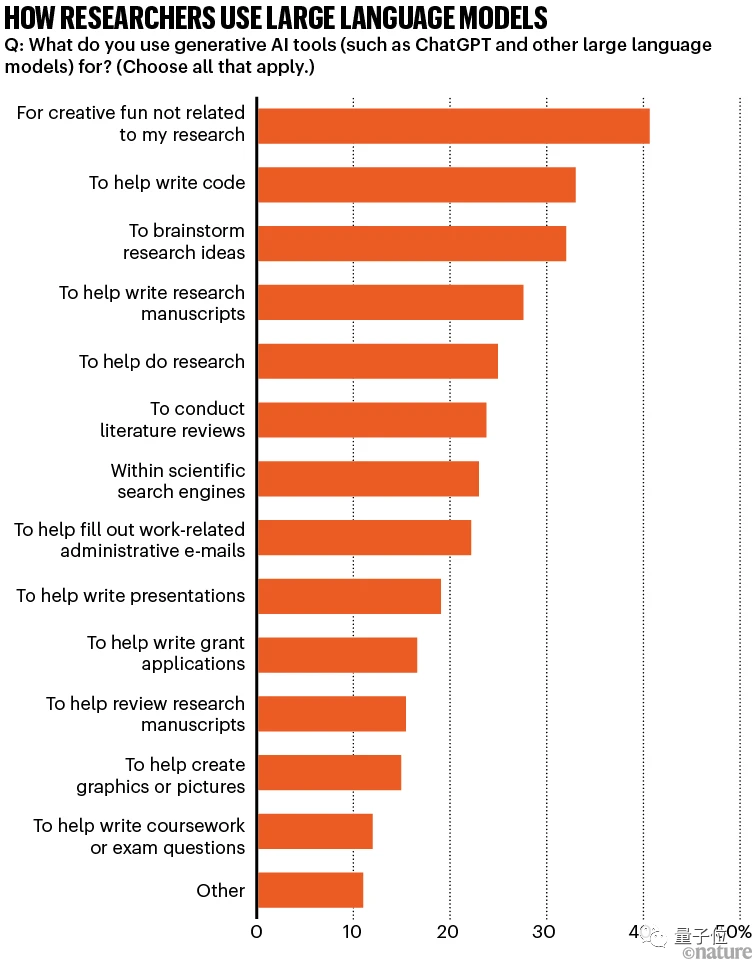

在所有被调查群体中,研究者们用AI做的最多的事儿是与研究无关的创意娱乐*;其次是用AI工具编写代码、构思研究思路、帮助撰写论文。

有一些科学家对大模型的输出并不满意。一位用大模型协助编辑论文的研究人员写道:

感觉ChatGPT已经复制了人类所有的不良写作习惯。

芬兰图尔库大学的物理学家Johannes Niskanen表示:

如果我们使用AI来阅读和撰写文章,科学很快就会从“for humans by humans”转变为“for machines by machines”。

在这项调查中,Nature还深入探究了研究人员对AI发展所面临的困境的看法。

AI发展所面临的困境

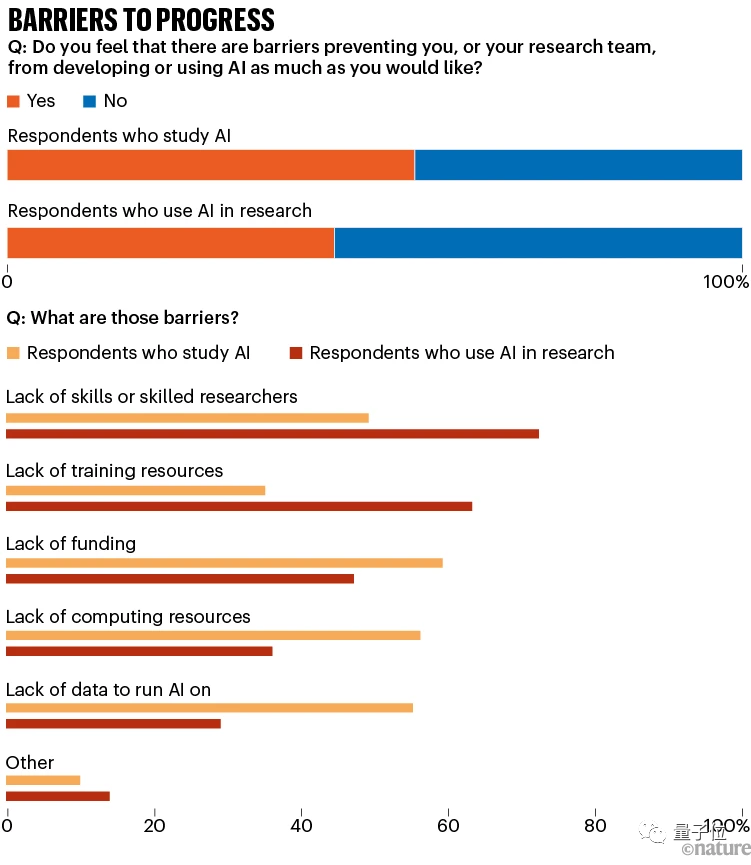

约一半的研究人员表示他们在开发或使用AI方面遇到了阻碍。

研究开发AI的研究人员最担心的问题是:计算资源不足、研究资金不足以及用于AI训练的高质量数据不足。

而在其他领域工作但在研究中使用AI的人则更担心缺乏具备足够技能的科学家和训练资源,还有安全和隐私。

不使用AI的研究人员表示他们不需要AI或认为AI不实用、又或者他们缺乏经验时间来研究这些AI工具。

值得一提的是,商业巨头主导了AI的计算资源和AI工具的所有权也是受访者关注的问题。

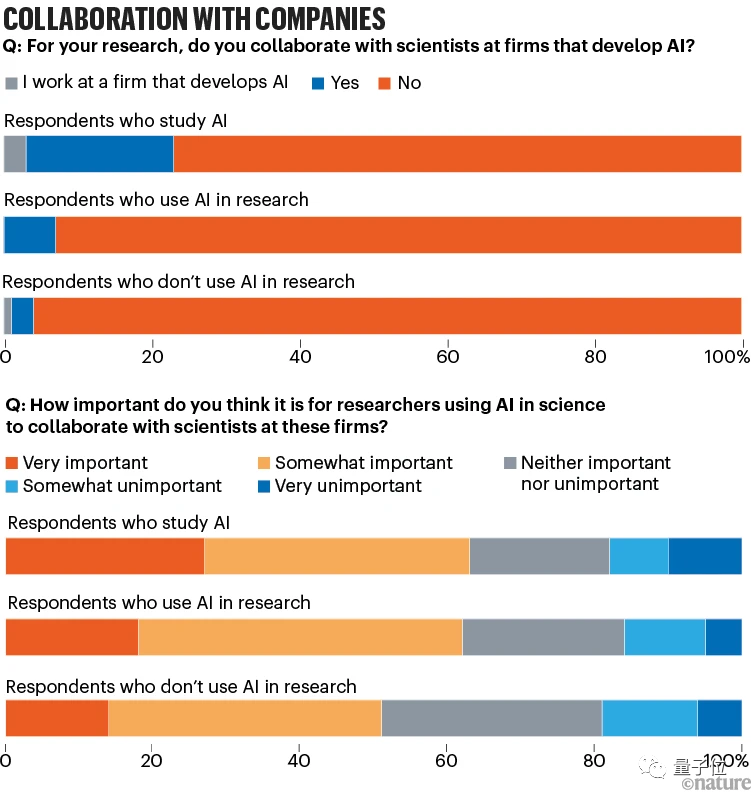

AI工具开发者中有23%表示,他们与开发AI工具的公司合作或就在这些公司工作(其中最常提到的是谷歌和微软),而仅使用AI的人中只有7%有这样的经历。

总体而言,过半受访者认为使用AI的研究人员与这些公司的科学家进行合作是“非常”或“有些”重要的。

除了开发,使用方面也出现了一些问题。

此前就有研究人员表示,在科学研究中盲目使用AI工具可能导致错误、虚假和无法重现的研究结果。

堪萨斯州立大学曼哈顿分校的计算机科学家Lior Shamir认为:

机器学习有时可能有用,但AI引发的问题要比它所提供的帮助多。科学家在不了解自己在做什么的情况下使用AI,就可能会导致虚假的发现。

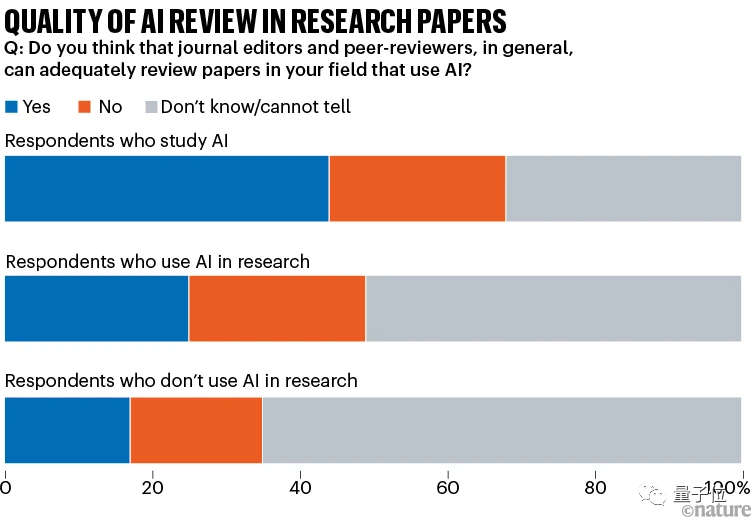

当被问及期刊编辑和同行评审员是否能够充分审查使用人工智能的论文时,受访者的意见不一。

在研究中使用AI但不直接开发AI的研究人员中,约一半人表示不确定,1/4认为审查是充分的,也有1/4认为审查不充分。而那些直接开发AI的研究人员则倾向于对编辑和审查过程持更积极的看法。

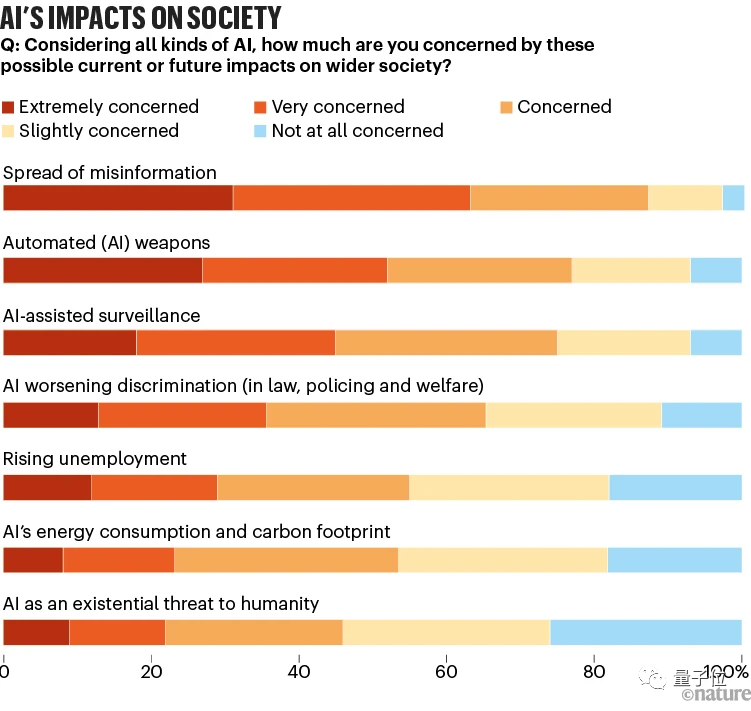

除此之外,Nature还询问了受访者对于AI在社会的7种潜在影响的担忧程度。

传播错误信息成为了研究人员最为担心的问题,2/3的人表示他们对此“非常担心”或“很担心”。

最不令人担心的是AI可能对人类构成生存威胁。

参考链接:https://www.nature.com/articles/d41586-023-02980-0

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。