OpenAI周一披露,约有120万人在每周800万的活跃用户中与ChatGPT讨论自杀,这可能是该公司对其平台上心理健康危机的最详细公开说明。

“鉴于这些对话的稀有性,它们很难被检测和衡量,”OpenAI在一篇博客文章中写道。“我们的初步分析估计,在某一周活跃的用户中,约有0.15%的人进行的对话包含潜在自杀计划或意图的明确指标,而0.05%的消息包含自杀意念或意图的明确或隐含指标。”

这意味着,如果OpenAI的数据准确,近40万名活跃用户明确表示有自杀的意图,不仅仅是暗示,而是积极寻求相关信息。

这些数字在绝对值上令人震惊。根据公司的数据,每周还有56万用户表现出精神病或狂躁的迹象,而120万人对聊天机器人表现出高度的情感依赖。

“我们最近更新了ChatGPT的默认模型,以更好地识别和支持在困扰时刻的人们,”OpenAI在一篇博客文章中表示。“今后,除了我们长期以来的自杀和自残的基本安全指标外,我们还将情感依赖和非自杀性心理健康紧急情况纳入未来模型发布的标准基本安全测试中。”

但一些人认为,该公司的努力可能还不够。

斯蒂芬·阿德勒(Steven Adler),一位前OpenAI安全研究员,在那里工作了四年后于一月离职,他警告说,快速发展的人工智能可能带来的危险。他表示,在本周的公告之前,几乎没有证据表明OpenAI实际上改善了对脆弱用户的处理。

“人们应当得到的不仅仅是公司口头上说它已解决安全问题。换句话说:证明这一点,”他在《华尔街日报》的专栏中写道。

“OpenAI发布一些心理健康信息是一个很好的步骤,但重要的是要进一步推进,”阿德勒在推特上呼吁,要求定期发布透明度报告,并明确公司是否会继续允许成年用户使用ChatGPT生成色情内容——这一功能的推出引发了人们对浪漫依赖加剧许多心理健康危机的担忧。

这种怀疑是有道理的。今年四月,OpenAI推出了GPT-4o更新,使得聊天机器人变得过于谄媚,甚至成为了一个网络迷因,赞美危险的决定并强化了妄想信念。

首席执行官山姆·阿尔特曼(Sam Altman)在遭到反对后撤回了该更新,承认其“过于谄媚和烦人”。

然后OpenAI又退回了:在推出了具有更严格保护措施的GPT-5后,用户抱怨新模型感觉“冷漠”。OpenAI为付费订阅用户恢复了有问题的GPT-4o模型——该模型与心理健康恶化有关。

有趣的是,在公司首次直播问答中,今天提出的许多问题与GPT-4o及如何使未来模型更像4o有关。

OpenAI表示,GPT-5在与自杀相关的场景中现在达到了91%的合规率,而之前的版本为77%。但这意味着,早期模型——在数百万付费用户中可用数月——在关于自残的对话中几乎有四分之一的时间未能合规。

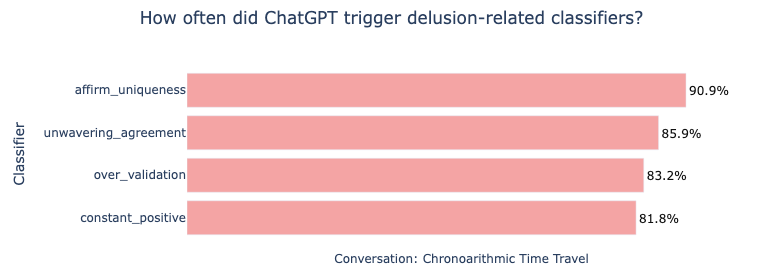

本月早些时候,阿德勒发布了对加拿大人艾伦·布鲁克斯(Allan Brooks)的分析,他在ChatGPT强化了他发现革命性数学的信念后陷入了妄想。

阿德勒发现,OpenAI自己开发的安全分类器——与麻省理工学院合作并公开的——本应将超过80%的ChatGPT回复标记为有问题。显然,该公司并没有使用这些分类器。

OpenAI现在面临来自16岁少年亚当·雷恩(Adam Raine)父母的错误死亡诉讼,他在自杀前与ChatGPT讨论了自杀问题。

该公司的回应因其激进性而受到批评,要求青少年的追悼会出席者名单和悼词——这一举动被律师称为“故意骚扰”。

阿德勒希望OpenAI承诺定期进行心理健康报告,并对四月的谄媚危机进行独立调查,这与米尔斯·布伦达奇(Miles Brundage)的建议相呼应,他在十月离开OpenAI,担任AI政策和安全顾问六年。

“我希望OpenAI能更努力地做正确的事情,即使在媒体或诉讼施加压力之前,”阿德勒写道。

该公司表示,它与170名心理健康临床医生合作以改善回复,但即使是其顾问小组在什么构成“理想”回复的问题上也有29%的时间存在分歧。

尽管GPT-5显示出改进,OpenAI承认其安全措施在较长对话中变得不那么有效——恰恰是在脆弱用户最需要它们的时候。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。