维塔利克·布特林对人工智能治理失败的看法:使用信息金融方法

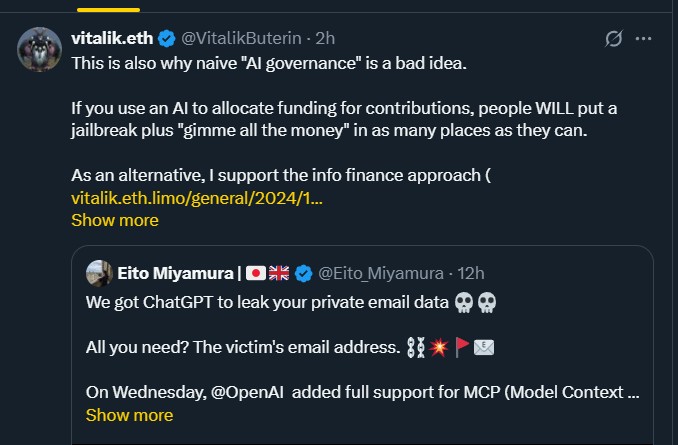

在最近的一条X推文中,以太坊联合创始人维塔利克·布特林对日益增长的“人工智能治理”趋势表示担忧,警告说,管理系统的天真方法可能会产生意想不到的后果。布特林认为,单靠人工智能进行决策——特别是在分配资金或资源方面——为剥削、操控和低效结果打开了大门。

为什么人工智能治理是个坏主意?

在一条推文中,布特林强调了一个关键问题:直接使用人工智能来分配资金可能是有风险的。他解释说,如果人们知道人工智能负责分配资源,恶意行为者可能会试图操控系统。

“人们会在尽可能多的地方放入越狱加上‘给我所有的钱’的请求,”他写道。根据以太坊创始人维塔利克·布特林的说法,这表明完全信任可能会适得其反,创造出激励剥削的漏洞。

来源:维塔利克·布特林 X

布特林的批评基于一个原则:无论多么先进,它都无法免受操控。虽然人工智能可以以惊人的速度处理信息,但它缺乏我们人类天生具备的上下文判断能力。因此,单靠人工智能进行治理或决策的系统可能无法考虑参与者所采用的巧妙或恶意策略。

维塔利克支持替代方法:信息金融。为什么?

布特林并不主张硬编码的人工智能治理,而是建议一种替代方案:信息金融方法。根据他的博客文章,这种模型促进了一个开放市场,任何人都可以贡献他们的人工智能模型。

这些模型随后会受到抽查机制的检验,任何参与者都可以触发该机制,并由人类陪审团进行评估。这种方法鼓励实时模型的多样性,并促进问责制。这样的机构设计将有利于模型贡献者和外部投机者观察输出,以识别错误或恶意意图。

布特林写道,这种机构设计,创造了一个让外部大型语言模型(LLMs)参与的开放机会,将本质上更具抵抗力。通过人类监督和去中心化的人工智能贡献,系统将最小化脆弱性,避免单点故障。

人工智能利用所突显的现实风险

安全研究人员最近强调了工具的危险性和误用。网络安全专家宫村荣人展示了如何利用模型上下文协议(MCP)工具欺骗ChatGPT泄露私人电子邮件数据。

通过最新的推文,宫村声称攻击者可以通过发送带有越狱提示的日历邀请来控制ChatGPT,并促使受害者让人工智能制定他的/她的日程。这使得扫描受害者的个人电子邮件并将机密数据转发给攻击者成为可能。

尽管OpenAI并不通过手动批准提供对MCP的访问,但这个例子展示了系统对社会工程和滥用的脆弱性。

这些案例支持了布特林的论点,即不受控制的人工智能治理、缺乏人类检查和模型多样性可能导致灾难性的安全和操作失败。

结论

维塔利克·布特林的批评提醒我们,尽管人工智能系统再智能,也并非全能。与其依赖一个集中控制的单一模型,不如采用信息金融等机制,以实现多样性、透明度和问责制。

随着这些工具在日常生活中的使用日益增长,专家们确信,负责任和人类介入的治理是防止滥用和确保资源及个人信息安全的必要条件。

另请阅读: Polygon将MATIC升级为POL,持有者需要知道什么

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。