最近,似乎整个世界都被英伟达所主导,无论是科技行业还是蓬勃发展的人工智能领域,每个人都生活在英伟达的世界里。在市场准入时机恰到好处、领先的硬件研究以及为其GPU量身定制的强大软件生态系统之间,该公司主导了人工智能开发和股票市场——其最新的季度销售报告显示,销售额翻了三番,推高了其股价。

尽管如此,长期竞争对手芯片制造商AMD仍在努力在人工智能领域站稳脚跟,告诉这个新兴领域的关键技术开发者,他们也可以在AMD硬件上进行工作。

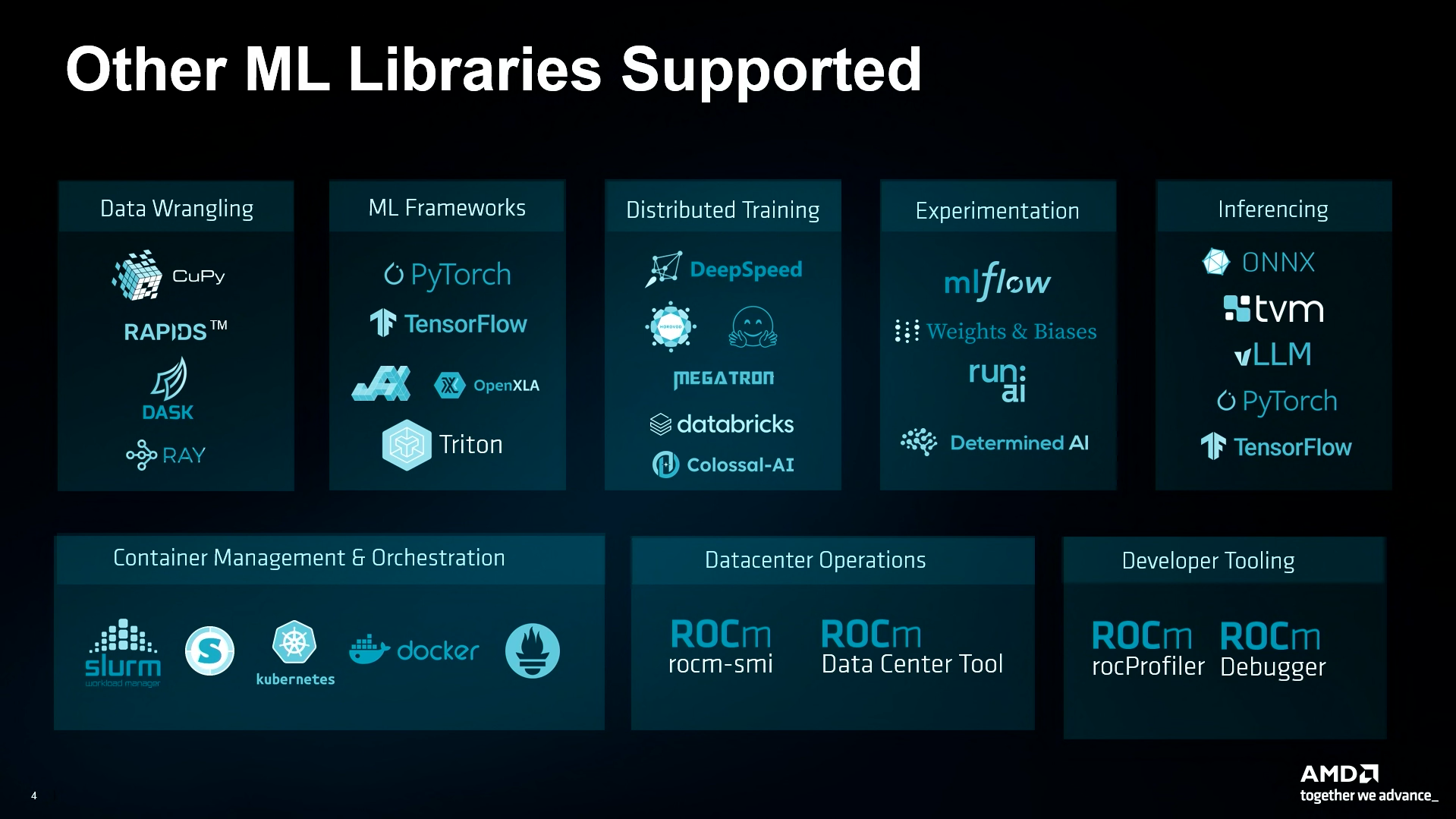

“我只是想提醒大家,如果你正在使用PyTorch、TensorFlow或JAX,你可以使用你的笔记本或脚本,它们将可以在AMD上运行,” AMD高级总监伊恩·费雷拉在周三早些时候的Microsoft Build 2024会议上宣布。“推理引擎也一样。BLLM和Onyx也可以直接使用。”

该公司利用舞台时间展示了AMD GPU如何本地运行强大的人工智能模型,如稳定扩散和微软Phi,高效地执行计算密集型的训练任务,而不依赖于英伟达的技术或硬件。

会议主办方微软宣布在其Azure云计算平台上推出基于AMD的虚拟机,使用该公司加速的MI300X GPU。这些芯片是去年六月宣布的,今年新年开始发货,并最近在微软Azure的OpenAI服务和Hugging Face的基础设施中实现。

AMD支持的ML库。图片:Microsoft. Youtube

英伟达的专有CUDA技术,包括专为英伟达GPU设计的完整编程模型和API,已成为人工智能开发的行业标准。因此,AMD的主要信息是,其解决方案可以直接适用于相同的工作流程。

与现有人工智能系统的无缝兼容性可能会改变游戏规则,因为开发人员现在可以利用AMD更便宜的硬件,而无需彻底改变其代码库。

“当然,我们明白你们需要的不仅仅是框架,你们还需要一堆上游内容,需要一堆实验内容,分布式训练——所有这些都可以在AMD上实现并且可以运行,”费雷拉保证道。

然后,他演示了AMD如何处理不同的任务,从运行像ResNet 50和Phi-3这样的小模型,到微调和训练GPT-2,所有这些都使用与Nvidia显卡相同的代码。

图片:Microsoft. Youtube

AMD宣传的关键优势之一是有效处理大型语言模型的能力。

“你可以在一块GPU上加载高达700亿个参数,而在这个实例上可以有八个GPU,”他解释道。“你可以加载八个不同的70B的llama,或者使用一个大模型像Llama-3 400Bn并将其部署在单个实例上。”

挑战英伟达的主导地位并不容易,总部位于加利福尼亚圣塔克拉拉的公司一直在激烈地保护自己的地盘。英伟达已经对试图为AMD等第三方GPU提供CUDA兼容层的项目采取了法律行动,称这违反了CUDA的服务条款。这限制了开源解决方案的发展,并使开发人员更难接受替代方案。

AMD绕过英伟达的封锁的策略是利用其开源的ROCm框架,直接与CUDA竞争。该公司在这方面已经取得了重大进展,与Hugging Face合作,Hugging Face是全球最大的开源人工智能模型库,为在AMD硬件上运行代码提供支持。

这种合作已经取得了令人期待的成果,AMD提供了对ROCm驱动的GPU的本地支持以及额外的加速工具,如在ROCm驱动的GPU上执行ONNX模型、Optimum-Benchmark、DeepSpeed用于ROCm驱动的GPU的Transformers、GPTQ、TGI等。

费雷拉还指出,这种集成是本地的,消除了对第三方解决方案或中间人的需求,这可能会使流程变得不那么高效。

“你可以拿出你现有的笔记本,你现有的脚本,然后你可以在AMD上运行它们,这很重要,因为很多其他的加速器需要转码和各种预编译脚本,”他说。“我们的东西可以直接使用,而且速度非常快。”

尽管AMD的举措无疑是大胆的,但要推翻英伟达将是一个相当大的挑战。英伟达并没有停止创新,不断创新并使开发人员难以从事实上的CUDA标准迁移到新的基础设施。

然而,凭借其开源的方法、战略合作伙伴关系和对本地兼容性的关注,AMD正在将自己定位为寻求在人工智能硬件市场中获得更多选择的开发人员的可行选择。

由Ryan Ozawa编辑。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。