去年大部分时间似乎一直在观望之后,苹果开始在人工智能领域——尤其是开源人工智能领域——掀起波澜。

这家总部位于库比蒂诺的科技巨头已经与圣巴巴拉大学合作开发了一种可以根据自然语言编辑图像的人工智能模型,就像人们与ChatGPT进行交互的方式一样。苹果将其称为多模态大语言模型引导图像编辑(MGIE)。

MGIE解释用户提供的文本指令,处理并完善这些指令以生成精确的图像编辑命令。整合扩散模型增强了这一过程,使MGIE能够根据原始图像的特征应用编辑。

多模态大语言模型(MLLMs)构成了MGIE方法的基础,它们可以处理文本和图像。与传统的专注于文本或图像的单模式人工智能不同,MLLMs可以处理复杂的指令并在更广泛的情况下工作。例如,一个模型可以理解文本指令,分析特定照片的元素,然后从图像中去掉某个元素并创建一张新的图片。

为了执行这些操作,人工智能系统必须具备不同的能力,包括生成文本、生成图像、分割和CLIP分析,所有这些都在同一个过程中进行。

MGIE的引入使苹果更接近于实现类似于OpenAI的ChatGPT Plus的功能,使用户能够与人工智能模型进行对话交互,以根据文本输入创建定制图像。有了MGIE,用户可以用自然语言提供详细的指令,比如“去掉前景中的交通锥”,这些指令将被转化为图像编辑命令并得到执行。

换句话说,用户可以从一张金发人的照片开始,只需说一句“让这个人变成红发”,就可以实现这个效果。在幕后,模型会理解指令,分割出人的头发,生成类似“红色头发,高度细节化,逼真的姜色调”的命令,然后通过修补执行这些变化。

苹果的方法与现有工具(如Stable Diffusion)一致,后者可以通过一个简单的界面进行文本引导的图像编辑。利用像Pix2Pix这样的第三方工具,用户可以使用自然语言命令与Stable Diffusion界面进行交互,实时观察编辑后图像的效果。

然而,苹果的方法证明比其他类似方法更准确。

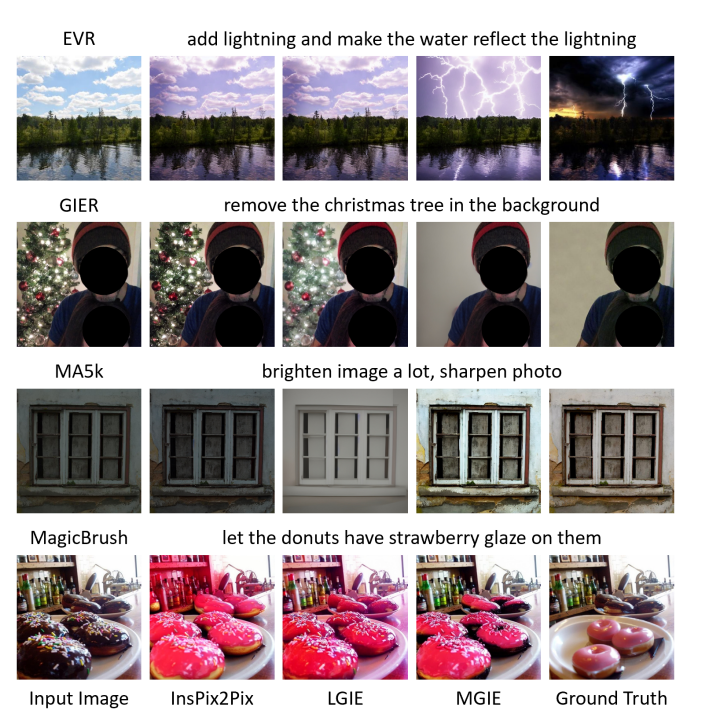

使用Instruct Pix2Pic、LGIE、苹果的MGIE和Ground Truth Image编辑图像的结果:苹果

除了生成式人工智能,苹果的MGIE还可以执行其他常规的图像编辑任务,如调色、调整大小、旋转、样式更改和素描。

为什么苹果要开源呢?

苹果的开源进程是一项明显的战略举措,其范围超出了简单的许可要求。

为了构建MGIE,苹果使用了Llava和Vicuna等开源模型。由于这些模型的许可要求限制了大型企业的商业使用,苹果很可能被迫在GitHub上公开分享其改进。

但这也使得苹果能够利用全球范围内的开发人员,以增强其实力和灵活性。这种合作比苹果完全独立开展工作并从头开始要快得多。此外,这种开放性激发了更广泛的想法,并吸引了多样化的技术人才,使MGIE能够更快地发展。

苹果参与开源社区的项目(如MGIE)也提升了该品牌在开发人员和技术爱好者中的声誉。这一方面并不是秘密,Meta和微软都在大力投资开源人工智能。

将MGIE作为开源软件发布,可能会让苹果在制定仍在不断发展的人工智能和基于人工智能的图像编辑行业标准方面占得先机。通过MGIE,苹果很可能为人工智能艺术家和开发人员提供了一个坚实的基础,以构建下一个大事件,提供比其他地方更准确和高效的解决方案。

MGIE肯定会让苹果的产品变得更好:将一条发送给Siri的语音命令合成为文本,然后用该文本编辑用户的智能手机、计算机或沉浸式头戴设备上的照片并不难。

精通技术的人工智能开发人员现在就可以使用MGIE。只需访问该项目的GitHub存储库。

由Ryan Ozawa编辑。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。