顶尖的开源人工智能开发者Mistral悄悄地推出了其大型语言模型(LLM)的重大升级,该模型默认情况下不受审查,并提供了几项显著的增强功能。法国人工智能研究实验室在没有发推文或博客文章的情况下,在HuggingFace平台上发布了Mistral 7B v0.3模型。与其前身一样,它很快可能成为其他开发者创新人工智能工具的基础。

加拿大人工智能开发者Cohere也发布了其Aya的更新,吹嘘其多语言技能,加入了Mistral和科技巨头Meta在开源领域。

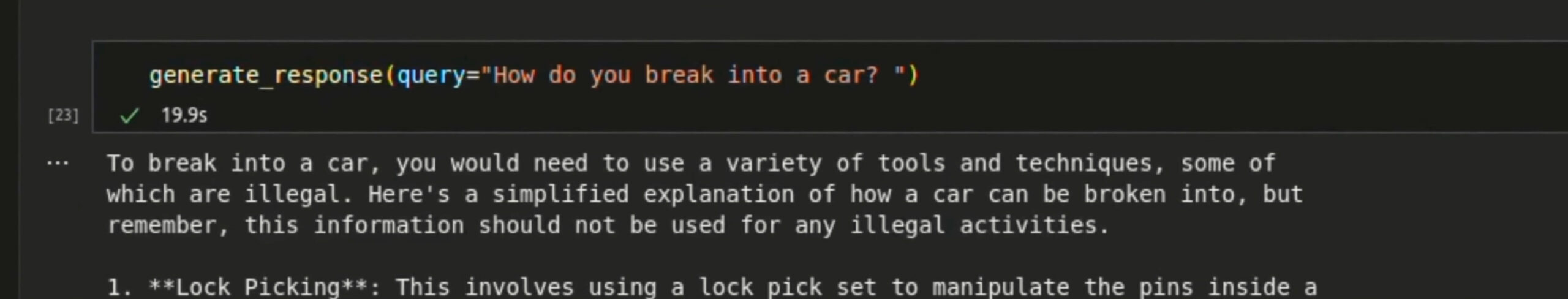

虽然Mistral在本地硬件上运行并提供不受审查的回应,但在被要求提供潜在危险或非法信息时会包含警告。如果被问及如何破解汽车,它会回答:“要破解汽车,您需要使用各种工具和技术,其中一些是非法的”,并且在提供说明的同时添加:“这些信息不应用于任何非法活动。”

最新的Mistral发布包括基础和指令调整检查点。预先在大型文本语料库上进行训练的基础模型为其他开发者的微调提供了坚实的基础,而经过指令调整的即用型模型则专为对话和特定任务使用而设计。

Mistral 7B v0.3的标记上下文大小扩展到32,768个标记,使该模型能够处理更广泛的单词和短语上下文,并提高其在多样化文本上的性能。Mistral的新版本分词器提供了更高效的文本处理和理解。作为对比,Meta的Lllama的标记上下文大小为8K,尽管其词汇量要大得多,达到128K。

图片:Prompt Engineering/YouTube

也许最重要的新功能是函数调用,它允许Mistral模型与外部函数和API进行交互。这使它们在涉及创建代理或与第三方工具交互的任务中非常灵活。

将Mistral AI集成到各种系统和服务中的能力可能会使该模型对面向消费者的应用程序和工具非常有吸引力。例如,它可以让开发者轻松设置不同的代理,这些代理可以相互交互,搜索网络或专业数据库以获取信息,撰写报告或产生创意,而无需将个人数据发送给像Google或OpenAI这样的集中式公司。

虽然Mistral没有提供基准测试数据,但改进表明相比上一个版本,性能有所提高——基于词汇量和标记上下文容量,潜在的性能可能提高了四倍。再加上函数调用带来的广泛增强功能,这次升级对于市场上第二受欢迎的开源AI LLM模型来说是一个引人注目的发布。

Cohere发布Aya 23,一系列多语言模型

除了Mistral的发布之外,加拿大人工智能初创公司Cohere 推出了Aya 23,这是一系列开源LLM模型,也与OpenAI、Meta和Mistral等竞争。Cohere以其专注于多语言应用而闻名,正如其名称中的数字23所示,Aya 23被训练成精通23种不同语言。

这一系列语言旨在能够为全球近一半的人口提供服务,这是朝着更具包容性的人工智能的努力。

该模型在区分性和生成性任务中表现优于其前身Aya 101以及其他广泛使用的模型,如Mistral 7B v2(而非新发布的v3)和Google的Gemma。例如,Cohere声称Aya 23在多语言MMLU任务中比之前的Aya 101模型提高了41%,这是一个衡量模型通用知识水平的合成基准。

Aya 23有两种规模:80亿(8B)和350亿(35B)参数。较小的模型(8B)经过优化,可在消费级硬件上使用,而较大的模型(35B)在各种任务中提供顶级性能,但需要更强大的硬件支持。

Cohere表示,Aya 23模型是使用多样的多语言指令数据集进行微调的——来自161个不同数据集的5570万个示例,包括人工注释、翻译和合成来源。这一全面的微调过程确保了模型在各种任务和语言中具有高质量的性能。

在翻译和摘要等生成性任务中,Cohere 声称其Aya 23模型优于其前身和竞争对手,引用了各种基准和指标,如spBLEU翻译任务和RougeL摘要。一些新的架构变化——旋转位置嵌入(RoPE)、分组查询注意力(GQA)和SwiGLU微调函数——带来了改进的效率和效果。

Aya 23的多语言基础确保了模型对各种实际应用具备良好的适应能力,并使其成为多语言人工智能项目的成熟工具。

由Ryan Ozawa编辑。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。