ArXiv是一个免费的存储库,成立于康奈尔大学,已成为全球数千名科学家和技术人员发布早期研究论文的首选中心,将不再接受计算机科学类别中的审查文章或立场论文,除非它们已经在期刊或会议上通过同行评审。

这一政策变化于10月31日宣布,是在一波“洪水”般的AI生成的调查论文之后,版主们将其描述为“不过是注释书目”。该存储库现在每月收到数百份此类提交,而历史上由资深研究人员撰写的高质量评论论文则仅为小量。

“在过去几年中,arXiv被论文淹没,”网站上的一份官方声明解释道。“生成性AI/大型语言模型通过使论文——尤其是那些没有引入新研究结果的论文——快速且容易撰写,进一步加剧了这一洪水。”

“我们做出这一决定是由于LLM辅助的调查论文大幅增加,”arXiv版主、人工智能促进协会前主席Thomas G. Dietterich在X上补充道。“我们没有足够的版主资源来审查这些提交,并识别出好的调查与坏的调查。”

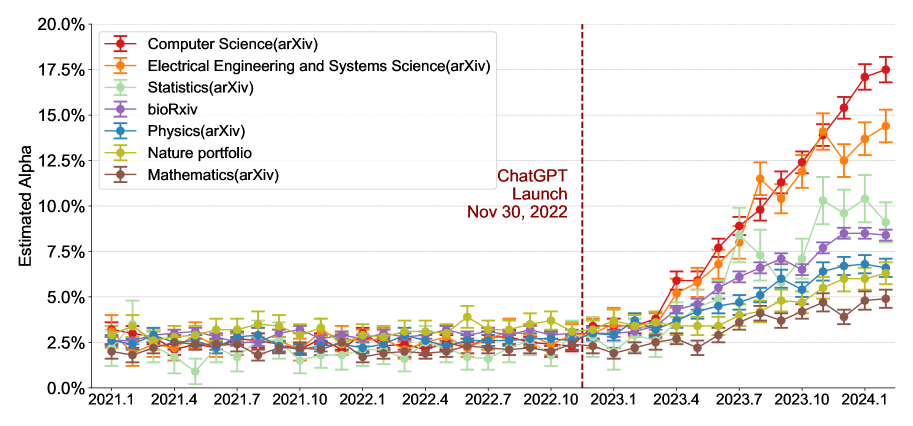

发表在Nature Human Behaviour上的研究发现,到2024年9月,近四分之一的计算机科学摘要显示出大型语言模型修改的证据。另一项在《科学进展》中的研究显示,自ChatGPT推出以来,2024年发表的研究论文中使用AI的情况激增。

来源:ArXiv

ArXiv的志愿版主一直在筛选提交的学术价值和主题相关性,但他们并不进行同行评审。审查文章和立场论文从未被正式接受为内容类型,尽管版主对来自知名研究人员或科学协会的工作做出了例外。然而,这一自由裁量制度在AI生成的提交量面前崩溃了。

该平台现在处理的提交量在近年来增加了数倍,生成性AI使得产生肤浅的调查论文变得极为简单。

研究界对此的反应不一。AI安全研究员Stephen Casper表示担忧,认为这一政策可能会对早期职业研究人员以及从事伦理和治理主题的研究人员产生不成比例的影响。

“审查/立场论文主要由年轻人、没有大量计算资源的人以及没有丰富出版经验的机构中的人撰写,”他在一篇批评中写道。

其他人则简单地批评ArXiv的立场是错误的(甚至是愚蠢的),还有人甚至支持使用AI来检测AI生成的论文。

一个问题是,AI检测工具已被证明不可靠,假阳性率高,可能不公平地标记合法工作。另一方面,最近的一项研究发现,研究人员未能识别出三分之一的ChatGPT生成的医学摘要为机器撰写。美国癌症研究协会报告称,尽管有强制披露政策,但不到25%的作者披露了AI的使用。

新的要求意味着作者必须提交成功同行评审的文档,包括期刊参考和DOI。研讨会评审将不符合标准。ArXiv强调,这一变化目前仅影响计算机科学类别,尽管其他部分如果面临类似的AI生成提交激增,也可能采取类似政策。

这一举措反映了学术出版界的更广泛反思。像CVPR 2025这样的主要会议已经实施了政策,对被标记为不负责任行为的评审者提交的论文进行拒绝。出版商正在应对那些明显含有AI特征的论文,例如一篇以“当然,这里是您主题的一个可能引言”开头的论文。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。