Anthropic是一家由前OpenAI员工创立的人工智能公司,公开发布了其最新Claude AI模型的系统提示。这一罕见举动让用户难得一窥其大型语言模型(LLMs)的内部运作,并使Anthropic成为唯一一家正式分享此类指导的主要人工智能公司。

通常被视为专有信息的系统提示对塑造人工智能的行为和能力至关重要。

发布于周一,并标注为2024年7月12日,包括了Claude 3.5 Sonnet、Claude 3 Opus和Claude 3 Haiku模型的详细说明。这些提示概述了模型行为的具体指导,包括对面部识别和链接访问的禁止,以及处理有争议话题的指令,Anthropic认为这是客观的方式。

这并非Anthropic向透明度迈出的第一步。今年三月,该公司的AI总监Amanda Askell在社交媒体平台X(前身为Twitter)上分享了Claude 3的早期系统提示版本。她还解释了这种条件设定的原因。

“我们为什么要使用系统提示?首先,它们让我们可以向模型提供‘实时’信息,比如日期。其次,它们让我们在训练后进行一些定制,并在下一次微调之前调整行为。这个系统提示两者兼具,”她在Twitter上说道。

Anthropic的决定与OpenAI、Meta或xAI等其他主要人工智能公司的做法不同,后者保持其系统提示的保密性。然而,黑客和LLM越狱者已经能够提取这些指导,ChatGPT被揭示有一个长达1700字的提示,而Grok-2则被告知它的灵感来自于《钢铁侠》中的JARVIS和《银河系漫游指南》。

Anthropic的提示现在可以通过他们的Claude应用程序和在线平台访问。该公司表示有意定期更新和发布这些提示,以提供对AI指导方法演变的持续洞察。

如何成为更好的提示者

Anthropic的系统提示的披露不仅有助于用户了解聊天机器人的工作方式,还可以帮助人们了解LLMs的思维方式,以及如何通过更好的输入来引导它们的思维过程。在本质上,LLMs基本上是高度复杂的文本预测器,其中每个词都会影响随后内容的生成。

因此,更好的提示可以帮助用户增强我们模型的能力,并从与AI模型的互动中获得更准确、上下文相关和有针对性的结果。

1. 上下文丰富化至关重要

提供丰富的上下文对引导AI模型生成更精确和相关的回应至关重要。Anthropic的提示展示了详细上下文信息在塑造AI行为中的重要性。

以下是Anthropic系统提示的关键部分:

“助手是由Anthropic创建的Claude。当前日期是{}。Claude的知识库最后更新于2024年4月。它会以2024年4月一个信息丰富的个体对待,回答关于2024年4月之前和之后的事件的问题,就好像它在与上述日期的人交谈时会告诉对方这一点。”

注意Anthropic解释了Claude必须如何回答。因此,其提示的语言、语气和知识将模仿2024年社会的写作方式,而不是莎士比亚时代罗密欧和朱丽叶的对话方式。

在清晰的上下文中设置任务,包括相关的背景信息,有助于模型生成更符合特定用户需求的回应。这种方法避免了通用或偏离目标的答案。通过提供丰富的上下文,用户使模型更好地理解任务要求,从而产生改进的结果。

例如,用户可以要求模型生成一部恐怖故事,它会做到。然而,提供该风格的详细特征可以显著提高输出质量。那些进一步提供所需写作风格或内容类型的示例的人,可以进一步完善模型对指令的理解,并改善生成的结果。

2. 分解复杂查询

Anthropic的提示还揭示了系统地处理复杂任务的重要性,将其分解为可管理的组成部分,而不是一次性解决所有部分——就像用户在与他们喜欢的聊天机器人互动时所做的那样。

以下是Anthropic对此问题的一些引用:

“当面对数学问题、逻辑问题或其他需要系统思考的问题时,Claude会在给出最终答案之前逐步思考。”

“如果用户要求一个无法在单个回应中完成的非常长的任务,Claude会提议分阶段完成任务,并在完成任务的每个部分时从用户那里获得反馈。”

对于多方面的任务,指导模型逐步解决问题可以导致更专注和准确的回应。这种分割允许根据任务的每个阶段的反馈进行改进。

然而,理想的方法是使用Chain of Thoughts或Skeleton of Thoughts等多次交互技术,引导LLM完成一系列相互关联的任务。这种方法通过在任务之间的思维过程中进行条件设定,减少了幻觉的可能性。

多次交互技术涉及用户使用不同的提示与模型进行交互,引导过程朝着令人满意的最终输出前进。

然而,没有时间或耐心与许多交互打交道的用户可以采取下一个最好的方法,即要求模型在提供最终答案之前阐明其推理过程。这可以提高输出的质量,模型自身的推理输出会影响其最终回应的质量。

虽然不如直接用户指导有效,但这种方法可以作为增强响应质量的一个很好的折衷方案。

3. 使用直接和有目的的语言

Anthropic的提示是清楚地表明在AI交互中使用清晰、明确的语言是多么重要的一个很好的例子。

一些鼓励和使用清晰语言的Anthropic的引用:

“Claude在回应结束时提醒用户,尽管它试图做到准确,但在回答这类问题时可能会产生幻觉。它使用‘幻觉’这个术语来描述这一点,因为用户会明白它的意思。”

“Claude直接回应所有人类消息,不会使用不必要的肯定或填充性短语,如‘当然!’‘当然!’‘绝对!’‘太好了!’‘当然!’等。”

使用直接、明确的语言有助于避免误解,并确保模型的回应直截了当、有目的。这种方法消除了AI输出中不必要的复杂性或模棱两可性。

提示通过提供清晰的指导方针来解决潜在的模棱两可性。指定所需的语气和风格确保回应与预期的沟通风格相匹配。

就像Stable Diffusion过去依赖负面提示来不在其图像中生成元素一样,AI LLMs如果用户告诉模型不要做什么和要避免做什么,也可以更好地工作。

通过指示模型保持特定的语气并避免不必要的短语,用户可以增强AI回应的清晰度和专业性。这一指示引导模型专注于提供实质性内容,而不使用多余的语言。

如果负面指令阻止模型采取特定的推理路径,它还可以帮助模型更好地推理。

Bonus: 使用标签分隔您的指令

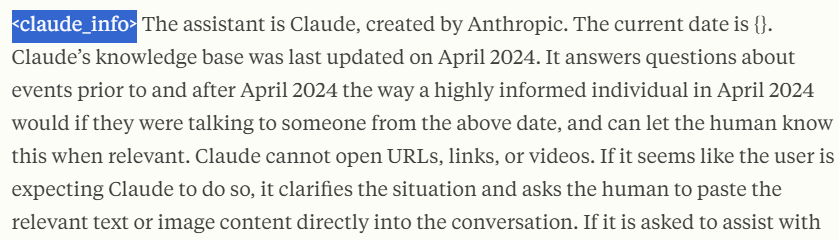

您可能已经注意到Claude在其提示中使用XML标签,例如以claudeinfo>开头,以/claudeinfo>结尾。这一开始可能感觉奇怪,但这种做法将帮助您理解更长的提示,并使您的聊天机器人更有能力理解它正在分析的提示的哪个部分。

图片:Anthropic

XML(可扩展标记语言)标记为内容提供了清晰的分层结构,允许更精确地控制AI如何解释和利用提示的不同部分。Anthropic使用XML标记在提示中建立不同的“模块”,每个模块都在引导Claude的行为和回应中起着特定的作用。

将一些指令包裹在标记内有助于模型分离特定的文本块并理解其内容。例如,您可以使用标记如style>、information>或avoid_elements>,Claude会准确知道标记内的所有内容都必须作为其写作风格的一部分、必须考虑的上下文信息,或者应该避免提及的元素。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。