Original Author: Jtsong.eth (Ø,G)(@Jtsong2)

Recently, the crypto research think tank @MessariCrypto released a comprehensive in-depth research report on 0G. This article is a summary of the key points in Chinese:

【Core Summary】

With the explosion of decentralized artificial intelligence (DeAI) in 2026, 0G (Zero Gravity), with its disruptive technological architecture, has completely resolved the historical problem of Web3 being unable to support large-scale AI models. Its core advantages can be summarized as follows:

Ultra-fast Performance Engine (50 Gbps Throughput): Through logical decoupling and multi-level parallel sharding, 0G has achieved a performance leap of over 600,000 times compared to traditional DA layers (such as Ethereum, Celestia), becoming the only protocol in the world capable of supporting real-time distribution of ultra-large models like DeepSeek V3.

dAIOS Modular Architecture: It pioneers a four-layer collaborative operating system paradigm of "settlement, storage, data availability (DA), and computation," breaking the traditional blockchain's "storage deficit" and "computational lag," achieving an efficient closed loop of AI data flow and execution flow.

AI Native Trusted Environment (TEE + PoRA): Through the deep integration of Trusted Execution Environment (TEE) and Proof of Random Access (PoRA), 0G not only addresses the "hot storage" needs of massive data but also builds a trustless, privacy-protected environment for AI inference and training, achieving a leap from "ledger" to "digital life foundation."

Chapter 1 Macro Background: The "Decoupling and Reconstruction" of AI and Web3

In the context of artificial intelligence entering the era of large models, data, algorithms, and computing power have become core production factors. However, existing traditional blockchain infrastructures (such as Ethereum, Solana) are facing severe "performance misalignment" when carrying AI applications.

1. Limitations of Traditional Blockchains: Bottlenecks in Throughput and Storage

The original design of traditional Layer 1 blockchains was to handle financial ledger transactions, not to support TB-level AI training datasets or high-frequency model inference tasks.

Storage Deficit: The data storage costs on chains like Ethereum are extremely high, and there is a lack of native support for unstructured big data (such as model weight files, video datasets).

Throughput Bottleneck: Ethereum's DA (data availability) bandwidth is only about 80KB/s, and even after the EIP-4844 upgrade, it is far from meeting the GB-level throughput requirements for real-time inference of large language models (LLMs).

Computational Lag: AI inference requires extremely low latency (in milliseconds), while blockchain consensus mechanisms often operate in seconds, making "on-chain AI" nearly unfeasible under the current architecture.

2. The Core Mission of 0G: Breaking the "Data Wall"

The AI industry is currently monopolized by centralized giants, forming a de facto "Data Wall," which restricts data privacy, makes model outputs unverifiable, and incurs high rental costs. The emergence of 0G (Zero Gravity) marks a deep reconstruction of AI and Web3. It no longer merely views blockchain as a ledger for storing hash values but decouples the "data flow, storage flow, and computation flow" required by AI through a modular architecture. The core mission of 0G is to break the centralized black box, allowing AI assets (data and models) to become publicly owned sovereign goods.

Having understood this macro misalignment, we need to delve into how 0G systematically addresses these fragmented pain points through a rigorous four-layer architecture.

Chapter 2 Core Architecture: The Four-Layer Collaboration of the Modular 0G Stack

0G is not a simple single blockchain but is defined as dAIOS (Decentralized AI Operating System). The core of this concept is that it provides AI developers with a complete protocol stack similar to an operating system, achieving an exponential leap in performance through deep collaboration across four layers.

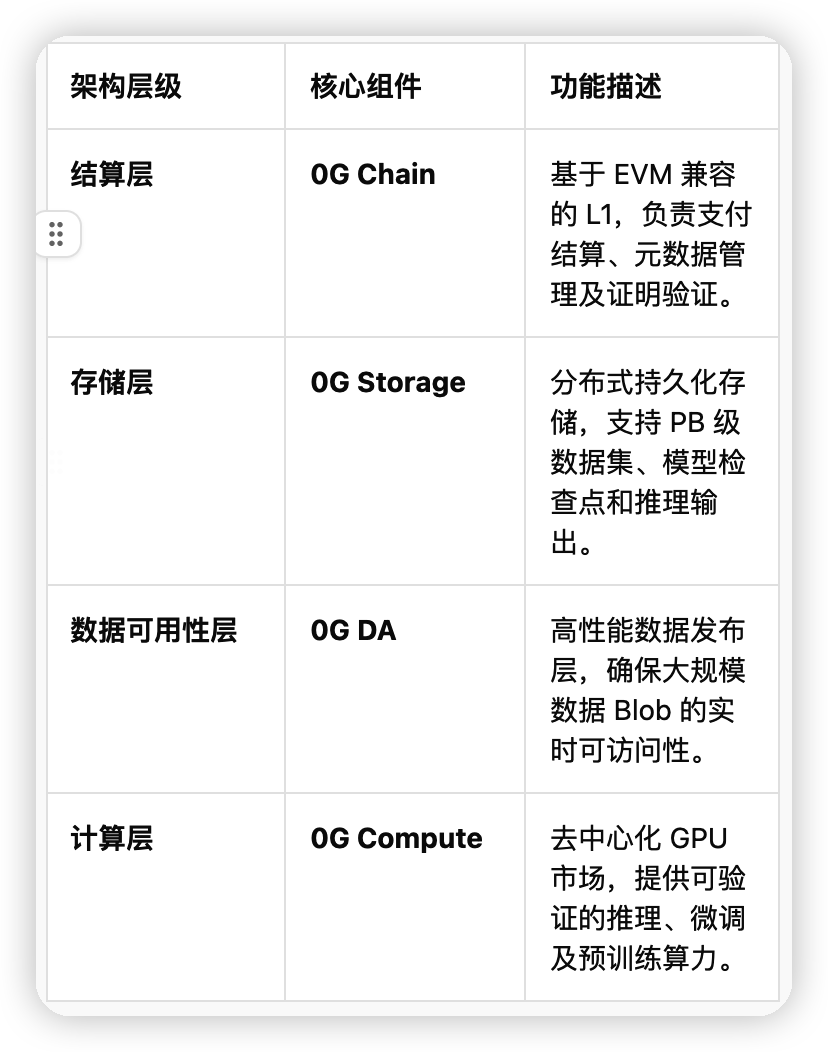

1. Analysis of the Four-Layer Architecture of dAIOS

The 0G Stack ensures that each layer can independently scale by decoupling execution, consensus, storage, and computation:

2. 0G Chain: Performance Foundation Based on CometBFT

As the neural hub of dAIOS, 0G Chain employs a highly optimized CometBFT consensus mechanism. Its innovation lies in separating the execution layer from the consensus layer and significantly reducing block production waiting times through pipelined parallel processing and modular design of ABCI. Performance Metrics: According to the latest benchmark tests, 0G Chain can achieve 11,000+ TPS throughput under a single shard, with sub-second finality. This extremely high performance ensures that on-chain settlement does not become a bottleneck during high-frequency interactions of large-scale AI agents.

3. Decoupled Collaboration of 0G Storage and 0G DA

The technological moat of 0G lies in its "dual-channel" design, separating data publishing from persistent storage:

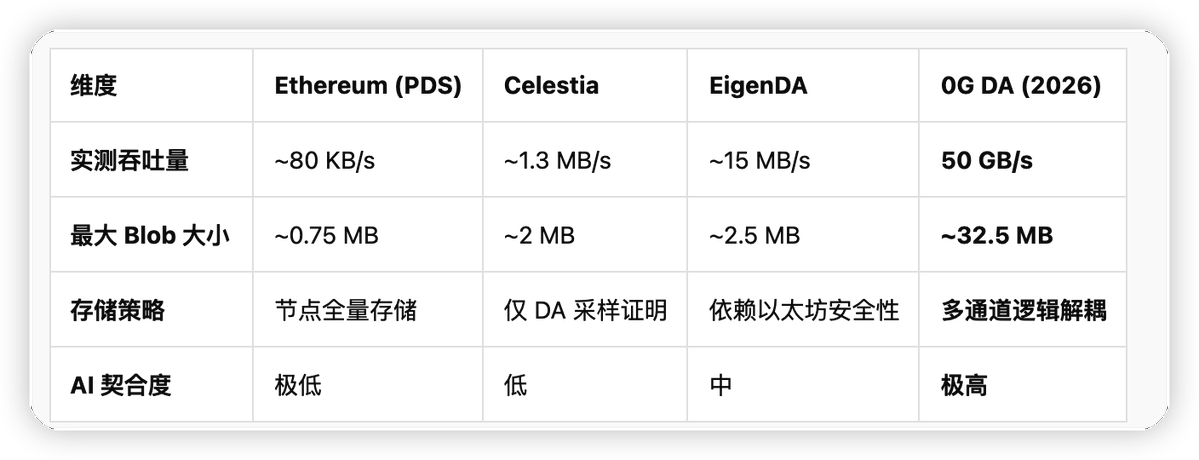

0G DA: Focused on the rapid broadcasting and sampling verification of Blob data. It supports a single Blob of up to approximately 32.5 MB, ensuring data availability even if some nodes are offline through erasure coding technology.

0G Storage: Handles immutable data through the "Log Layer" and dynamic state through the "KV Layer."

This four-layer collaborative architecture provides fertile ground for the growth of a high-performance DA layer. Next, we will delve into the most impactful part of the 0G core engine—high-performance DA technology.

Chapter 3 Deep Dive into High-Performance DA Layer (0G DA)

In the decentralized AI ecosystem of 2026, data availability (DA) must not only be "proof of publication" but also support real-time pipelines for PB-level AI weight files and training sets.

3.1 Logical Decoupling and Physical Collaboration: The Generational Evolution of the "Dual-Channel" Architecture

The core superiority of 0G DA stems from its unique "dual-channel" architecture: logically decoupling data publishing from data storage while achieving efficient collaboration at the physical node level.

Logical Decoupling: Unlike traditional DA layers that conflate data publishing with long-term storage, 0G DA is solely responsible for verifying the accessibility of data blocks in a short time, while the persistence of massive data is handled by 0G Storage.

Physical Collaboration: Storage nodes utilize Proof of Random Access (PoRA) to ensure data authenticity, while DA nodes ensure transparency through a sharded consensus network, achieving "instant verification and storage verification."

3.2 Performance Benchmark: Leading Data Confrontation

The breakthrough in throughput of 0G DA directly defines the performance boundary of the decentralized AI operating system. The table below shows a comparison of technical parameters between 0G and mainstream DA solutions:

3.3 Technical Foundation for Real-Time Availability: Erasure Coding and Multi-Consensus Sharding

To support massive AI data, 0G introduces Erasure Coding and Multi-Consensus Sharding:

Erasure Coding Optimization: By increasing redundancy proofs, even if a large number of nodes are offline, complete information can still be recovered through sampling small data fragments.

Multi-Consensus Sharding: 0G abandons the linear logic of a single chain processing all DA. By horizontally expanding the consensus network, total throughput increases linearly with the number of nodes. In 2026, it supported tens of thousands of Blob verification requests per second, ensuring the continuity of AI training flows.

Having a high-speed data channel alone is not enough; AI also requires a low-latency "brain storage" and a secure, private "execution space," leading to the introduction of the AI-specific optimization layer.

Chapter 4 AI-Specific Optimization and Enhanced Secure Computing Power

4.1 Addressing Latency Anxiety for AI Agents

For AI agents executing real-time strategies, data read latency is a critical survival line.

Cold and Hot Data Separation Architecture: 0G Storage is internally divided into immutable log layers (Log Layer) and variable state layers (KV Layer). Hot data is stored in the high-performance KV layer, supporting sub-second random access.

High-Performance Index Protocol: Utilizing distributed hash tables (DHT) and dedicated metadata index nodes, AI agents can locate the required model parameters in milliseconds.

4.2 TEE Enhancement: The Final Piece in Building Trustless AI

In 2026, 0G fully introduced TEE (Trusted Execution Environment) security upgrades.

Computational Privacy: Model weights and user inputs are processed in the "isolation zone" within the TEE. Even node operators cannot peek into the computation process.

Result Verifiability: The remote attestation generated by the TEE is submitted to the 0G Chain along with the computation results, ensuring that the results are generated by a specific, unaltered model.

4.3 Vision Realization: The Leap from Storage to Operating System

AI agents are no longer isolated scripts but digital life entities with sovereign identities (iNFT standard), protected memories (0G Storage), and verifiable logic (TEE Compute). This closed loop eliminates the monopoly of centralized cloud vendors over AI, marking the entry of decentralized AI into the era of large-scale commercialization.

However, to support these "digital lives," the underlying distributed storage must undergo a performance revolution from "cold" to "hot."

Chapter 5 Innovation in Distributed Storage Layer—From "Cold Archiving" to "Hot Performance" Paradigm Revolution

The core innovation of 0G Storage lies in breaking the performance shackles of traditional distributed storage.

1. Dual-Layer Architecture: Decoupling of Log Layer and KV Layer

Log Layer (Stream Data Processing): Designed specifically for unstructured data (such as training logs, datasets). By using an append-only mode, it ensures that massive data achieves millisecond-level synchronization across distributed nodes.

KV Layer (Index and State Management): Provides high-performance indexing support for structured data. When retrieving model parameter weights, it reduces response latency to the millisecond level.

2. PoRA (Proof of Random Access): Anti-Sybil Attack and Verification System

To ensure the authenticity of storage, 0G introduces PoRA (Proof of Random Access).

Anti-Witch Attack: PoRA directly links mining difficulty to the actual physical storage space occupied.

Verifiability: Allows the network to conduct random "spot checks" on nodes, ensuring that data is not only stored but also in a "readily available" hot activation state.

3. Performance Leap: Engineering Implementation of Second-Level Retrieval

0G achieves a leap from "minute-level" to "second-level" retrieval through the combination of erasure coding and high-bandwidth DA channels. This "hot storage" capability rivals that of centralized cloud services.

This leap in storage performance provides a solid decentralized foundation to support models with tens of billions of parameters.

Chapter 6 AI Native Support—Decentralized Foundation for Models with Tens of Billions of Parameters

1. AI Alignment Nodes: Guardians of AI Workflows

AI Alignment Nodes are responsible for monitoring the collaboration between storage nodes and service nodes. By verifying the authenticity of training tasks, they ensure that AI models operate without deviating from preset logic.

2. Supporting Large-Scale Parallel I/O

Handling models with tens of billions or hundreds of billions of parameters (such as Llama 3 or DeepSeek-V3) requires extremely high parallel I/O. 0G allows thousands of nodes to simultaneously process large-scale dataset reads through data slicing and multi-consensus sharding technology.

3. Checkpoints and High-Bandwidth DA Collaboration

Fault Recovery: 0G can quickly persist checkpoint files at the hundred GB level.

Seamless Recovery: Thanks to the 50 Gbps throughput limit, new nodes can instantly synchronize the latest checkpoint snapshots from the DA layer, addressing the pain point of maintaining long-term decentralized large model training.

Beyond the technical details, we must broaden our vision to the entire industry and see how 0G is sweeping the existing market.

Chapter 7 Competitive Landscape—0G's Dimensional Crushing and Differentiated Advantages

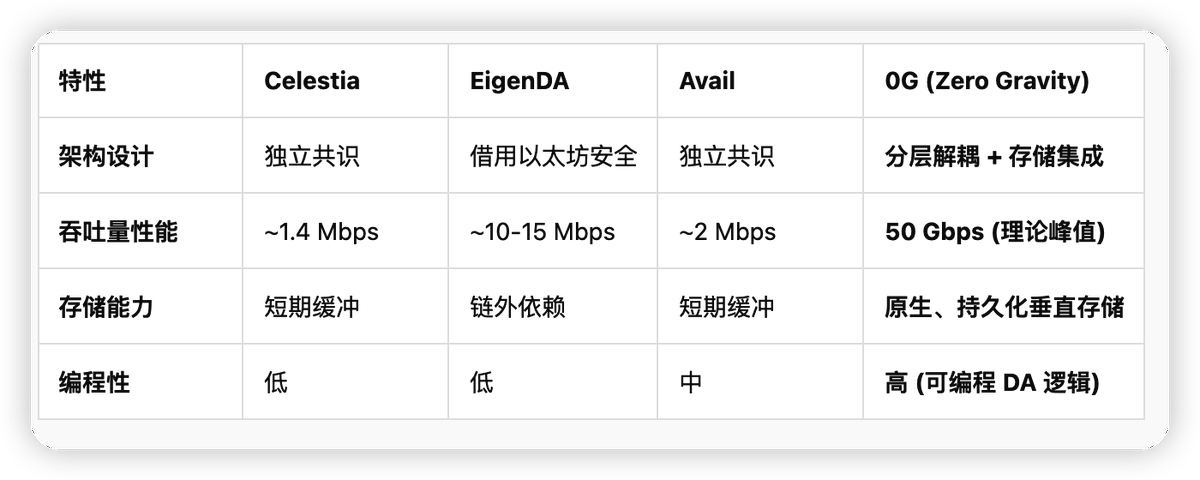

7.1 Horizontal Evaluation of Mainstream DA Solutions

7.2 Core Competitiveness: Programmable DA and Vertically Integrated Storage

Eliminating Transmission Bottlenecks: The native integration of the storage layer allows AI nodes to directly retrieve historical data from the DA layer.

Leap in Throughput to 50Gbps: Several orders of magnitude faster than competitors, supporting real-time inference.

Programmability (Programmable DA): Allows developers to customize data allocation strategies and dynamically adjust data redundancy.

This dimensional crushing foreshadows the rise of a massive economy, with token economics serving as the fuel driving this system.

Chapter 8 2026 Ecological Outlook and Token Economics

With the stable operation of the mainnet in 2025, 2026 will be a key node for the explosion of the 0G ecosystem.

8.1 $0G Token: Multi-Dimensional Value Capture Pathways

Resource Payment (Work Token): The only medium for accessing high-performance DA and storage space.

Security Staking: Validators and storage providers must stake $0G to provide network profit sharing.

Priority Allocation: During busy periods, the amount of tokens held determines the priority of computational tasks.

8.2 2026 Ecological Incentives and Challenges

0G plans to launch the "Gravity Foundation 2026" special fund, focusing on supporting DeAI inference frameworks and data crowdfunding platforms. Despite its technological leadership, 0G still faces challenges such as high hardware thresholds for nodes, cold start of the ecosystem, and compliance.

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。